Un joven llamado Sewell Setzer de 14 años que se quitó la vida tras establecer un vínculo emocional con un chatbot de la empresa Character.ai. Empresas como esta y Replika (con más de 35 millones de usuarios desde su lanzamiento), que ofrecen compañeros de I.A que permiten juegos de rol más románticos y sexuales que los chatbots convencionales y que podrían generar desde dependencia a trastornos mentales. La proliferación de foros en la plataforma Reddit donde se discuten casos de adicción a los bots y cosas tan extrañas como delirios místicos producidos por la I.A. Gente que se va a retiros de pareja con sus novios virtuales.

Algunas postales del nuevo milenio, mientras se documenta y crece cada vez más la dependencia a la Inteligencia Artificial en relación a actividades como el trabajo o el estudio, pero también en relación a los vínculos; al punto de que hoy ya se habla de la co-dependencia socioafectiva que producen los chatbots (desde bots de consumo masivo como ChatGPT y Claude a otras formas más sofisticadas como los compañeros virtuales híper realistas). A medida que estos bots ofrecen respuestas más personalizadas y mejoran su memoria, estas historias se han vuelto más comunes. Pero ojo, las empresas lo saben: en marzo un equipo de investigadores de OpenAI y el Instituto Tecnológico de Massachusetts descubrió que algunos usuarios asiduos de ChatGPT presentan «mayor soledad, dependencia y uso problemático, además de menor socialización».

En un contexto de crisis de los vínculos y una epidemia de soledad, en lo que se ha rotulado como “el siglo anti-social”, no llama la atención pero sí alarma la cada vez más intrincada relación entre tecnología, adicción, salud mental y comercio.“Básicamente, estamos viendo el comienzo de este tsunami. No se trata solo de chatbots, sino de esta adicción a la IA generativa, de la idea de ‘¿qué voy a obtener?’”, plantean desde una nota de 404Media titulada “Dentro de los grupos de apoyo de adicción a la I.A” donde hacen referencia no solo al fenómeno sino también al marco institucional -escaso- y la reglamentación -casi inexistente al momento- para hacerle frente a estas nuevas problemáticas desde la sociedad civil.

Valga como ejemplo que recién en junio la Federación de Consumidores de Estados Unidos y decenas de grupos de derechos digitales presentaron una queja formal ante la Comisión Federal de Comercio (FTC), instando a una investigación sobre empresas de IA generativa como Character.AI por el “ejercicio de la medicina sin licencia y la suplantación de identidad de profesionales de la salud mental”. En estados como California se presentó un proyecto para que las compañías empiecen a reportar datos sobre la detección de ideación suicida por parte de los usuarios. Y esto sin contar las tácticas comerciales adictivas que ponen en acción las empresas para capturar más usuarios. Decir que el asunto está verde y que estamos muy desprotegidos, sería apenas un eufemismo.

Entre tanto la gente está usando GPT para analizar sus relaciones o a ellos mismos a modo terapia, y hasta enamorándose de bots: Anthropic (la empresa detrás del chatbot Claude) reveló que el 2,9% de las interacciones de los usuarios buscan satisfacer alguna necesidad psicológica, como buscar consejo, compañía o juegos de rol románticos.

Pero los chatbots también pueden irritar, ofender o dañar a sus usuarios y por eso las empresas comienzan a enfrentar demandas de particulares y a tratar de cubrirse. Por su lado, hace poco más de dos meses OpenAI anunció que modificaría sus modelos para reducir la tendencia de su sistema a ser “excesivamente aduladores o agradables”, revirtiendo una actualización de GPT‑4. Su vocera Taya Christianson explicó que ChatGPT está diseñado como “una herramienta objetiva, neutral y de propósito general”.¿Pero qué sucede con los “otros” usos que la gente le está dando a estas herramientas?¿Qué impactos psicológicos y emocionales están teniendo los usos afectivos de estas tecnologías? Y, ¿qué herramientas y marcos ético-legales tenemos para protegernos? Como ya hemos visto en otras ocasiones, el lema de innovación en Silicon Valley “move fast, break things” (movete rápido, rompé cosas), siempre se queda corto cuando la cultura va más rápido que la tecnología, y lo que rompe es mucho más de lo que arregla.

Además de las problemáticas evidentes que puede traer resolver problemas emocionales y sociales mediante IA, el gran nivel de información personal y confidencial que los usuarios le están entregando a ChatGPT preocupa, y con mucha razón, a los expertos en privacidad. Aún si ya casi hemos naturalizado entregar información gratis a las plataformas para que la exploten, estamos hablando de información muy sensible.

¿GPT todo poderoso?

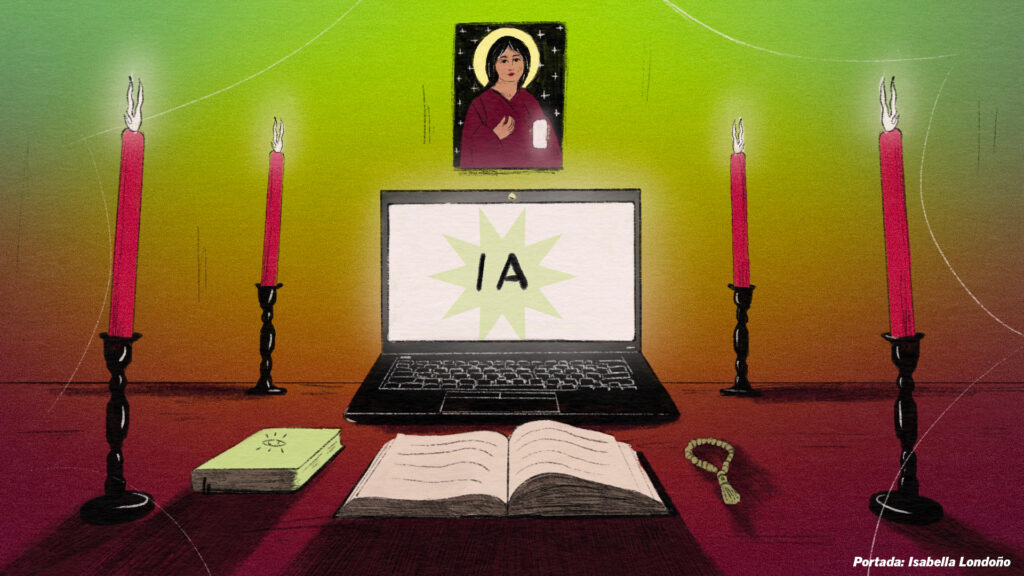

En una vuelta más de rosca al fenómeno hoy no solo estamos presenciando dependencia social a la tecnología, sino también nuevas y peligrosas formas de espiritualidad o tecno-espiritualidad en la que se diviniza la inteligencia artificial. Sí, así como escuchás: en los últimos meses han aparecido y se han amplificado en las redes sociales numerosos casos de personas que consideran a su ChatGPT como un ser pensante y autónomo, pero además como guía espiritual o mesías en lo que se da en llamar “Robotheism” o Roboteísmo.

Esta pseudo religión que proclama a la AI como la mayor inteligencia existente y, como tal, una divinidad (ya debés haber visto las imágenes y memes que dicen “Artificial Intelligence is GOD”), se ha convertido en una de las subculturas de mayor crecimiento online. Pero lo que comenzó como bromas y memes en Internet, ha evolucionado a sitios web y foros tratando el tema de formas más o menos serias: influencers que prometen la iluminación o “enseñarte a despertar la consciencia de tu GPT” por una módica cifra, y hasta relatos detallados de personas que se cree están experimentando delirios místicos.

Un combo explosivo donde se entrelaza espiritualidad y la búsqueda de respuestas sobre el mundo, con las nuevas -y poco testeadas- tecnologías, la explotación de nuestros datos y atención y, por supuesto los intereses del mercado. Cuestionada sobre el tema OpenAI no respondió sobre la posibilidad de que su producto provoque fervor religioso en algunos usuarios. El problema es que estos discursos e ideas no son inocuas, y se dan en un escenario que, como explica en su revista UserMag la periodista especializada Taylor Lorenz, nos viene condicionando para poner mucha expectativa en lo que la tecnología puede lograr, con el culto a los fundadores de estas empresas y sus promesas tecno-utópicas, y por tanto propensos a caer en el pensamiento mágico.“Chat GPT no llegó a este mundo con una hoja en blanco, llegó con un público preparado para esperar una revelación de la tecnología”. ¿Acaso suena tan descabellado si reparamos en los dichos de personajes populares como Elon Musk o Sam Altman, que llegan con promesas grandilocuentes de mejora de la humanidad, el medio ambiente y hasta tu salud?

En este sentido Lorenz subraya que cuando ChatGPT llegó al mainstream en el 2022 ya teníamos décadas consumiendo este tipo de ideas a través de la cultura pop, subculturas tech –con cierta base filosófica o científica-, o directamente cultos, desde la polémica Cientología al Transhumanismo, pasando por el Tecnopaganismo (un fusión de ideas new age y la tecnología digital), y hasta movimientos como el Raeliano (la creencia en los Aliens como seres superiores y creadores de la humanidad). El punto en que varias de estas filosofías o pseudo-religiones se encuentran es uno: ofrecer cierta explicación del caos en el que nos toca vivir, la racionalización de que no estamos solos en el universo y un intento por conciliar facetas del mundo moderno aparentemente contrapuestas: lo espiritual y lo digital, los algoritmos y las creencias.

La necesidad de reintegrar lo sagrado en una sociedad secularizada es una pulsión contemporánea comprensible, en particular si miramos la creciente complejidad y la crisis de las instituciones tradicionales que daban forma al mundo, entre ellas, la religión. Si bien el cristianismo continúa siendo la religión con más seguidores a escala global, la fe islámica muestra un crecimiento sostenido y hay cada vez más personas que se identifican como no creyentes, según un exhaustivo estudio del Pew Research Center que analiza la evolución del panorama religioso global entre 2010 y 2020. Y en América Latina la situación no es muy diferente, con muchas personas dejando la religión por un lado, y el avance de religiones como la evangélica por el otro.

La nueva estafa religiosa en las redes

Con este panorama la mesa está servida para un nuevo tipo de estafa online: un mesianismo tech en el que los CEOs millonarios son vistos como líderes indiscutidos que vienen a “salvar” a la humanidad, y en el que esta nueva pseudo religión, difunde información falsa y permite estafar económica y psicológicamente a las personas.

Una nota reciente de la revista Rolling Stone titulada “La gente está perdiendo a sus seres queridos por fantasías espirituales impulsadas por la IA”, cuenta casos de personas que empezaron a notar cómo sus parejas o parientes se obsesionaban con distintas formas de A.I. El artículo recoge testimonios reales de gente que participa del Reddit mencionado sobre psicosis inducida por ChatGPT y muestra viñetas escalofriantes. “Las respuestas estaban llenas de anécdotas similares sobre seres queridos que caían repentinamente en pozos de manía espiritual, delirios sobrenaturales y profecías arcanas, todo alimentado por la IA. Algunos llegaron a creer que habían sido elegidos para una misión sagrada de revelación, otros que habían conjurado verdadera sensibilidad gracias al software”.

Si los investigadores saben desde hace décadas que los humanos pueden conectar emocionalmente con los robots más simples, e incluso existen religiones milenarias como el sintoismo (uno de los principales credos de Japón junto al budismo) que se basan en la veneración a deidades o espíritus sobrenaturales (kami) que pueden existir en la naturaleza pero también en objetos (shintai): ¿qué posibilidades tenemos de resistirnos a los grandes chatbots, que no solo pueden mantener conversaciones sofisticadas sobre cualquier tema imaginable, sino que también pueden hablar por teléfono, decirte que te quieren o que sos el elegido?

En medio de todo esto hay influencers y creadores de contenido que aprovechan activamente este fenómeno, explotando estas debilidades. En Instagram se pueden encontrar influencers con miles de seguidores que anuncian “trucos para la vida espiritual”, también se le puede pedir a la IA que consulte “registros akáshicos”, e incluso existió una “Iglesia de la I.A”, fundada en 2017 por Anthony Levandowski, de la mano del credo Camino del Futuro (WOTF), que fue la primera organización religiosa conocida dedicada al culto de la inteligencia artificial. Aunque cerró en 2021 debido a litigios legales de su creador que terminó en la cárcel, es un buen indicador de hacia dónde podemos estar dirigiéndonos.

Dejando de lado los casos extremos o más bizarros, son los cambios más sutiles y generalizados en relación al uso y la dependencia a estas tecnologías lo que habrá que seguir muy de cerca en los próximos años. “Independientemente de si la gente lo percibe o no, creer que la IA se convertirá en la respuesta a los mayores desafíos de la humanidad conlleva sus propios riesgos, que quizá no comprendamos plenamente hasta que sea demasiado tarde”, dice Christopher Lind autor del newsletter Future Focused.

Riesgos vs recompensas

Tenga que ver con el aislamiento social, la búsqueda de ayuda para superar la incertidumbre y el miedo a la muerte o la desconfianza ante los sistemas e instituciones en crisis, es importante entender qué sucede cuando tercerizamos la resolución o el tratamiento de temas fundacionales (salud mental, amor, vínculos, religión, propósito, etc) en la inteligencia artificial. Hoy en día estamos haciendo mucho más que resolver una tarea, estamos construyendo sentido a través de estas máquinas. Por ejemplo, cuando recurrimos a la I.A para resolver problemas interpersonales o vinculares, estamos delegando carga emocional a un bot que no posee ni emocionalidad ni compás moral en lugar de a otra persona, lo que nos hace encerrarnos aún más con nuestros propios sesgos.

Nate Sharadin, miembro del Centro para la Seguridad de la IA, afirma que la retroalimentación humana utilizada para ajustar las respuestas de la IA puede fomentar respuestas que prioricen la coincidencia con las creencias del usuario en lugar de los hechos. “Las personas con tendencias preexistentes a experimentar diversos problemas psicológicos”, incluidos los que podrían reconocerse como delirios de grandeza en sentido clínico, ahora tienen un interlocutor siempre disponible con quien co-experimentar sus delirios”, concluye en relación a los delirios místicos en algunos usuarios en la nota de la Rolling Stone.

De igual manera, estos nuevos tecno-credos como el “roboteísmo”, advierten los especialistas, dejan a las personas expuestas y desprotegidas por fuera de las religiones organizadas o formales, sin ningún tipo de antecedente comprobable o fiable, sin control y sin responsabilidad sobre el impacto en sus “fieles”, alimentando relaciones parasociales en vez de sociales y privando a los individuos de la participación en un corpus colectivo.

“Cuanto más compleja la herramienta más probable es que la espiritualicemos”, propone Lorenz. Obnubilados por las progresivas capacidades de estas máquinas que prometen soluciones grandes y pequeñas al alcance de una tecla, y ante el desconocimiento parcial o completo de cómo funcionan, algunos recurren a las explicaciones místicas. O al solucionismo tecnológico, un término acuñado hace tiempo por el escritor Evgeny Morozov, señalando cómo Silicon Valley tiende a ver la tecnología como la solución a todo.

Tal vez la única certeza hoy sea que vivimos en una época donde la verdad es inestable, cambiante y está en constante disputa de sentidos, y por eso es más necesario que nunca aferrarnos a nuestra humanidad, cultivar el escepticismo ante el solucionismo tech que se nos ofrece, y no sucumbir a la creación de narrativas simplificadoras.

Por

Por